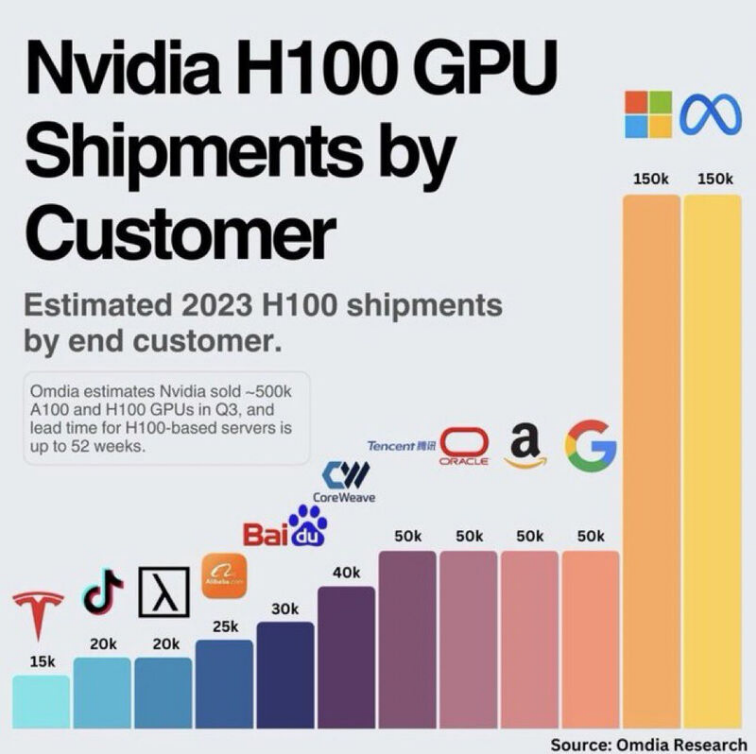

1. H100 기업별 2023년 구매량

H100은 시장 최고의 AI 칩이며 성능 면에서 높은 평가를 받고 있다. H100은 불과 2년 전에 출시된 이전 세대의 A100에 비해, 최대 9배 더 빠른 AI 훈련과 최대 30배 더 빠른 AI 추론을 제공한다. H100 기반 서버의 리드 타임은 36~52주입니다. (Omdia는 최대 52주를 예상)

시장 추적 회사인 Omdia는 Meta 와 Microsoft 가 Nvidia H100 GPU의 최대 구매자라고 예상한다. 그들은 각각 150,000개의 H100 GPU를 구매했는데, 이는 Google, Amazon, Oracle 및 Tencent가 구매한 H100 프로세서 수 (각각 50,000개)보다 훨씬 많은 것이다.

2. 메타 2024년 H100 35만대 구입 예정

메타가 인공일반지능(AGI) 연구를 위해 연내 엔비디아의 AI 반도체 H100을 35만 개 이상 구입한다. 마크 저커버그 메타 최고경영자(CEO)는 AGI 연구가 회사의 장기 비전라는 입장이다.

2024년 1월 18일(현지시간) CNBC 보도에 따르면, 저커버그 메타 CEO는 자신의 인스타그램을 통해 “올해 말까지 회사의 컴퓨팅 인프라에 35만 개의 H100을 포함하는 게 목표”라며 “궁극적으로 H100을 포함해 60만 개 이상의 그래픽 카드(GPU)를 확보할 것”이라고 밝혔다.

엔비디아의 고성능 AI 칩 H100은 1대당 수천만원을 호가하는 가격에도 불구하고 AI 연산에 탁월한 성능을 보이며 지난해에만 150만 대가 팔린 인기 제품이다.

H100는 최소 2만5천 달러(약 3천300만원) 수준에 거래되고 있다. 이베이에서는 1개당 4만 달러(약 5천360만원)를 호가하기도 한다.

만약 메타가 H100을 2만5천 달러 선에서 구매했을 경우, 예상되는 지출 비용은 약 90억 달러(약 12조원)로 추산된다.

메타는 2023년 2월 대규모 언어모델인 '라마'(LLaMA)를 공개했다. 오픈AI의 'GPT'처럼 텍스트를 학습해 사람이 말하고 쓰는 것과 유사한 문장을 생성할 수 있다. 메타는 라마를 필요와 목적에 따라 용량을 골라 사용할 수 있도록 4개의 모델로 내놓았다. 오픈AI의 GPT-3.5나 구글 람다와 비교하면 규모는 작지만, 더 많은 데이터를 학습해 성능을 고도화했다. 컴퓨팅 파워가 적게 소요되고 반응속도가 빠르다는 장점도 있다.

라마 출시를 계기로 메타 CEO 마크 저커버그는 생성 AI를 연일 강조하고 있다. 생성 AI 관련 전담 조직을 신설하고 생성 AI 기술을 메타 여러 플랫폼에 통합하겠다는 계획이다.

인스타그램 필터나 릴스 제작과 광고 도구에 생성 AI 기술이 적용되고, 왓츠앱이나 페이스북 메신저에 챗봇이 등장하게 될 것이라는 예측이 힘을 얻고 있다.

전 세계 20억 명이 사용하는 페이스북과 인스타그램에 매일 쌓이는 엄청난 데이터를 고려하면 메타의 인공지능 성능은 급속도로 고도화될 수 있는 잠재력을 지니고 있다. 메타가 생성 AI를 가장 비즈니스 친화적으로 활용할 수 있는 회사라는 평가받는 이유다.

'반도체 > 반도체 주식' 카테고리의 다른 글

| HBM - 예상 가격 및 삼성전자 SK하이닉스 예상 매출 (0) | 2024.02.16 |

|---|---|

| 반도체 수도 만든다 - 4월 총선 양향자 용인갑 예비후보 등록 (8) | 2024.02.15 |

| NVIDIA 데이터 센터 GPU - A100, H100, H200, B100 (66) | 2024.01.28 |